如果要说现在最火热的技术项目,那么它一定是人工智能。从智能聊天机器人ChatGPT问世开始,各种AI技术快速发展,“AI换脸”就是其中之一。最初的AI换脸技术大多还是被用于影视业后期处理需求,后来作为一种娱乐方式走入大众生活,而现在,AI换脸却被不法分子盯上,成为实施诈骗的重要工具。

AI换脸诈骗

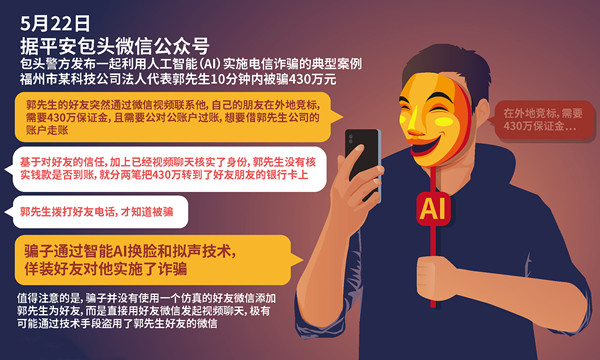

近日,福州市某企业法定代表人郭先生10分钟内被人用AI换脸诈骗430万元的新闻迅速冲上热搜。在人们还在关注案件详情时,又一起AI换脸诈骗再次引发舆论关注。此次案件中,诈骗分子使用了一段9秒钟的智能AI换脸视频,佯装“熟人”,让受害人放松警惕从而实施诈骗,导致何先生被诈骗245万。

两起案件都是利用AI换脸技术,伪装成受害者亲朋,再通过声音合成技术,伪造人物声音,利用网络视频通话,博取受害者信任后实施诈骗。

中国互联网协会发文提醒,使用AI换脸后的表情自然,能够以假乱真,面对利用AI技术的新型骗局,广大公众需提高警惕,加强防范。

如何防范AI换脸诈骗?

社交账号方面

这两起AI诈骗案件有一个共同点,那就是受害者在接到朋友社交账号发来的视频时,总是先入为主的认为就是朋友本人,从而降低了防范心理。再加上视频打开确实是自己朋友的面容,这更容易让我们信任对方所说的话。

因此,源头上我们应该先防止自己的账号被盗用,使用高强度密码进行保护,其次还要警惕他人社交账号的真伪,尽可能通过多渠道验证对方身份。

视频画面方面

专家指出,AI换脸目前在连续动作的实时渲染方面还是会存在技术缺陷,比如在说话的时候嘴部动作、眼部动作,如果仔细看都会存在一定的“不和谐”情况,如丢帧、嘴巴时大时小等问题。

而且,AI换脸的纹理特征也存在破绽,比如伪造后的视频人物的眼睛或牙齿轮廓细节容易不一致;两只眼睛瞳孔的颜色不一样或瞳孔中心反射的细节不一样;很多伪造视频由于视频分辨率低于原始视频,伪造出来的视频牙齿边缘过于整齐等。

由于这些问题的存在,诈骗分子往往不会长时间播放AI换脸的视频,在获取对方信任后,便会匆匆转到文字聊天。

所以,我们在和朋友视频通话时,要尽可能的注意观察画面显示情况,如出现上述问题,一定要提高警惕心理,避免上当受骗。

个人信息方面

警方提醒,在生活中我们要保护好个人信息,不要轻易透露自己的身份证、银行卡、验证码等信息,不要轻易提供人脸、指纹等个人生物信息给他人,不过度公开或分享动图、视频等。

如果有人以“熟人”、“领导”等身份通过社交软件、短信等方式以各种理由诱导汇款,或涉及网络转账交易行为时,务必需要通过电话、见面等多途径核验对方身份,不要未经核实随意转账汇款。如果不慎被骗或遇可疑情形,一定要注意保护证据,并立即拨打报警电话。

AI技术是一把“双刃剑”,它既可以让我们的生活工作更加便利,同时也可能成为不法分子的诈骗工具。因此,需要相关部门制定有效的法律法规对AI行业进行相应的约束。而我们也一定要提高自身的防范意识,并时刻向身边的家人朋友普及相关的反诈防骗知识。

免责声明:素材源于网络,如有侵权,请联系删稿。